Husker du spillerne som hadde hundrevis av tenåringer som spilte Axie Infinity for at de skulle tjene magiske kjærlighetsdrikker?

Ja, det var 4 år siden.

Nå kan du bare trene og spinne opp 100 autonome kodekoperatører for å spille for deg i stedet

... og tjene penger på det og selge det til andre

✅ AI x robotikk

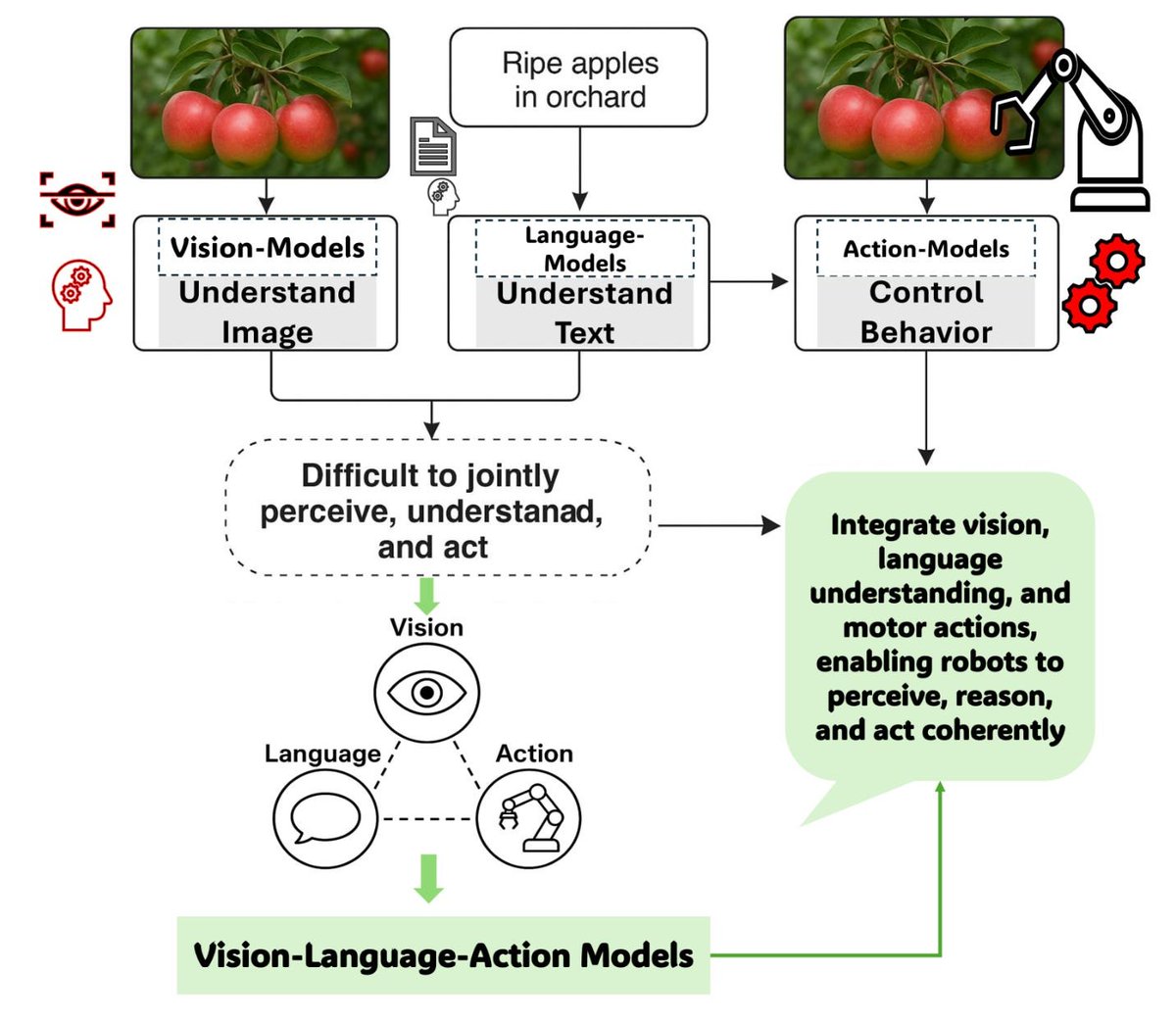

AI x Robotics-fortellingen varmes opp for ordentlig med VLA-modeller

På dette stadiet i AI-økosystemet bruker de fleste protokoller og agenter tekstbaserte LLM-motorer eller statiske skjermbilder for å tolke data

Men bare husk at det meste av den virkelige verden ikke har API-tilgang, du trenger visjon, beslutninger og handlinger. Den virkelige verden må sees i piksler, og det er her VLA-modeller kommer inn

@Codecopenflow muliggjør automatisering av programvare og robotikk gjennom visjon ved hjelp av en teknologistabel bygget fra bunnen av

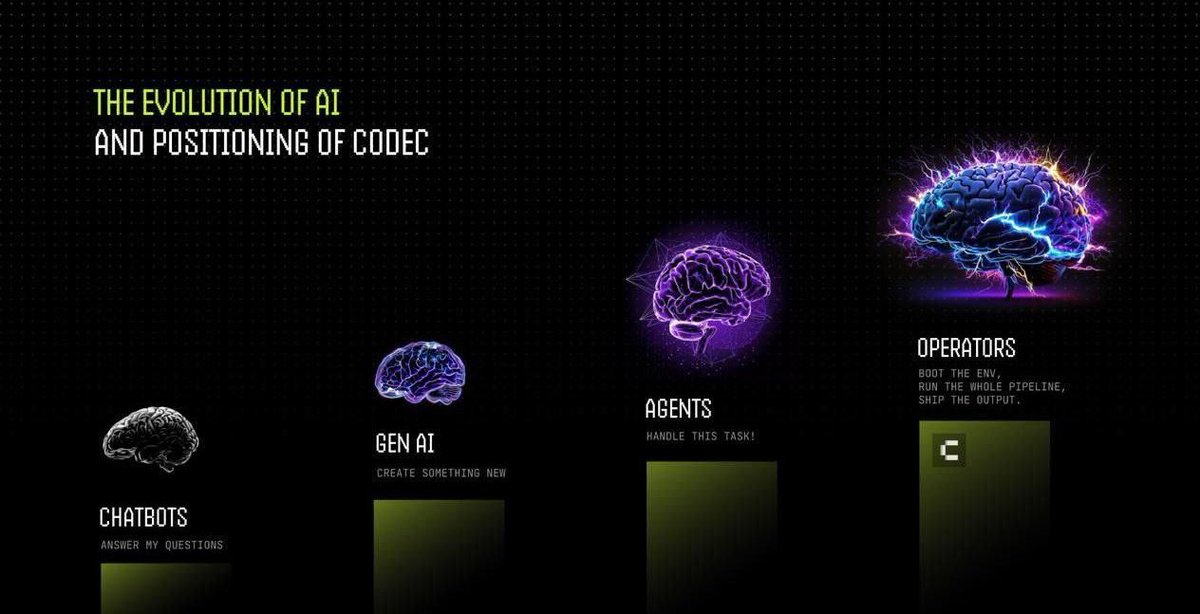

✅ CODEC-operatører

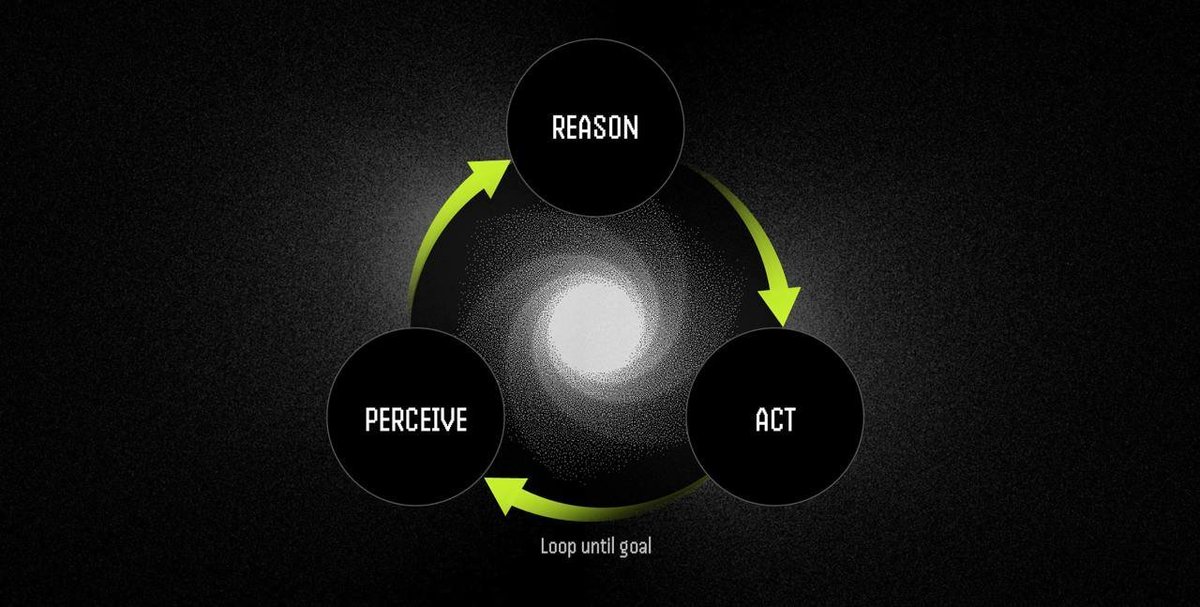

Operatører er autonome programvareagenter som kan utføre oppgaver gjennom en oppfatte-fornuft-handle-syklus. Muligheten til å se skjermen (eller kamerafeeder eller sensordata) lar dem ta beslutninger LLM-er ikke ville være i stand til å gjøre

• Oppfatning: Tar skjermbilder, kamerafeeder eller sensordata

• Resonnement: Behandler observasjoner og instruksjoner ved hjelp av synsspråkmodeller

• Handling: Utfører beslutninger gjennom UI-interaksjoner eller maskinvarekontroll

I en kontinuerlig sløyfe

Operatørene kan kjøre på bare-metal-servere, virtuelle maskiner (på alle operativsystemer), eller til og med på roboter.

Hver operatør får automatisk en dedikert databehandlingsmaskin (isolert virtuell maskin eller beholderforekomst), og kan sikres med TEE-er (isolering på maskinvarenivå) for sensitiv kode og data.

✅ AI-intelligenslag

Operatørene kan konfigureres til å bruke en eller flere modeller (LLM eller VLA) kombinert som sin "hjerne"

For eksempel, ved å pare den rimelige Mixtral-8×7B-språkmodellen med åpen kildekode CogVLM-visjonsmodellen kan operatører lese tekst på skjermen og tolke live skjerm- eller kamerafeeder - alt til en brøkdel av GPT-4s kostnad.

En VLA-modell (Vision-Language-Action) lar agenten tolke visuelle inndata og deretter bestemme seg for en handling basert på hva den ser

✅ Bruksområder

🔹 Automatisering av skrivebord

Kan automatisere repeterende kontoroppgaver ved å kontrollere GUI-er. Som å fylle ut regneark, oppdatere kalendere eller andre oppgaver som krever GUI-interaksjon

Kan håndtere UI-oppdateringer da den faktisk kan se hva den gjør

🔹 Spillagenter

Operatører kan kontrollere spillere eller teste videospill. Agentene strømmer skjermen og kan utføre handlinger basert på det de ser ved å sende tastatur- eller musekommandoer til spillet.

Kan brukes til QA-testing, eller til og med avanserte NPC-motstandere eller automatisering av web3-spill

🔹 Robotics

Operatører kan kontrollere fysiske roboter. Maskinlaget vil koble seg til en robots maskinvare med sensorer og aktuatorer, og agenten kan sende kommandoer for å bevege en arm eller navigere.

For eksempel kan den fange en kamerafeed av objekter som beveger seg på et transportbånd og gjøre handlinger basert på bevegelsen. Hvis det er en hindring i veien, kan operatøren se den og kontrollere roboten for å unngå den

✅ Datainnsamling og Onchain sikkerhetsskinner

Ved å bringe informasjonen om operatørene onchain til Solana, kan de tilby uforanderlige handlingslogger fra alle handlinger som utføres

I fremtiden kan vi se et punkt der robotselskaper vil bli pålagt å satse et token for å garantere at operatørene deres ikke vil få en robot til å ta fysisk kontakt med et menneske over en viss kraft. Hvis de bryter det, vil de bli kuttet for en del av det stakede tokenet (som EigenLayer / Symbiotic restaking)

✅ Opplæringsmiljø for robotikk

Med Codec kan utrente virtuelle modeller distribueres til et dynamisk treningsområde med høy kvalitet, uten behov for fysisk robot.

Simuler, lær opp og finjuster kompleks atferd i skyskala, og overfør deretter disse policyene til ekte maskinvare med tillit.

Treningsmiljøer kan raskt spinnes opp for alle typer operatører (programvare, spill eller robotikk)

✅ SDK for kodek

En fullstendig SDK og API er utviklet slik at utviklere enkelt kan distribuere operatørene sine

✅ Markedsplass for operatører

Operatører kan (i fremtiden) selges på en tilpasset markedsplass.

Det vil være en inntektsdeling slik at du kan sende og tjene penger på VLA-operatøren din, noe som betyr at hvis du trener effektive operatører, kan du ha ekstra inntektsstrømmer

✅ Avsluttende tanker

Jeg tror vi vil se en massiv utvikling på VLA-feltet i løpet av det neste året. Vi har sett hvor raskt LLM-er utvikles, det var bare noen få år siden GPT-1 ble lansert. Robotikk og synsmodeller vil med stor sannsynlighet bli en het fortelling på et tidspunkt i denne syklusen, og jeg liker å bli posisjonert tidlig

Åh, og nevnte jeg at medgründerne er fra Hugging Face og Elixir-spill 👀

Merk: Slappjakke har store $CODEC vesker, og dette er en av de gangene jeg ble enda mer bullish mens jeg skrev denne tråden og la til enda flere

Dette er som alltid ikke økonomisk rådgivning og en høyrisikoinvestering, så gjør din egen research.

Vis originalen

8,93k

105

Innholdet på denne siden er levert av tredjeparter. Med mindre annet er oppgitt, er ikke OKX forfatteren av de siterte artikkelen(e) og krever ingen opphavsrett til materialet. Innholdet er kun gitt for informasjonsformål og representerer ikke synspunktene til OKX. Det er ikke ment å være en anbefaling av noe slag og bør ikke betraktes som investeringsråd eller en oppfordring om å kjøpe eller selge digitale aktiva. I den grad generativ AI brukes til å gi sammendrag eller annen informasjon, kan slikt AI-generert innhold være unøyaktig eller inkonsekvent. Vennligst les den koblede artikkelen for mer detaljer og informasjon. OKX er ikke ansvarlig for innhold som er vert på tredjeparts nettsteder. Beholdning av digitale aktiva, inkludert stablecoins og NFT-er, innebærer en høy grad av risiko og kan svinge mye. Du bør nøye vurdere om handel eller innehav av digitale aktiva passer for deg i lys av din økonomiske tilstand.